Антитролль, болото данных и этичность: что обсуждали эксперты на конференции «MLeчный путь»

Какие стадии проходят модели машинного обучения? Почему в компаниях не хотят внедрять сложные ML-решения? И какая она – идеальная система? Специалисты в сферах ML и искусственного интеллекта собрались на конференции «MLечный путь. Автостопом по галактике ML» 16 сентября офлайн в Санкт-Петербурге (в офисе компании Selectel, организатора встречи) и онлайн. В центре внимания спикеров были вопросы практического внедрения технологий machine learning в бизнес-процессы, или так называемый MLOps.

Путь данных

Каковы стадии жизненного цикла моделей машинного обучения? Их обозначил Михаил Александров, главный конструктор в компании Polymatica. Сначала идут формулировка гипотезы, поиск и подготовка данных. Эксперт отметил, что важно оценить, насколько данные подходят для обучения, какой у них профиль, достоверны ли характеристики их источника. Необходимо также учитывать, что профиль данных постоянно меняется. Поэтому его нужно исследовать и сохранять в привязке ко времени.

После того, как модель построена и отправлена в репозиторий (хранилище), следует этап ее согласования со всеми заинтересованными сторонами. Лишь после этого модель можно публиковать, то есть осуществлять запуск онлайн-сервиса (скажем, банковского), пакетного продукта (например, таблицы) или автономного (скрипта). Дальнейшие этапы – мониторинг и переобучение (если точность модели упала).

Спикер добавил, что платформа Polymatica ML 1.0 позволяет проводить исследование данных, строить модели машинного обучения и управлять ими.

«Когда данных становится много, нужно подключать платформу по обработке big data», – убежден Иван Сидоров, директор по инновациям ITSumma.

Он рассказал, какой путь проходят данные при создании ML-платформы и как организован процесс хранения данных в компании.

Чтобы данные стали пригодными для построения модели, их нужно структурировать – в несколько этапов. Прежде всего формируется «озеро данных» (Data Lake). Обычно это распределенная файловая система HDFS (Hadoop Distributed File System), в которую попадет все, что нужно, и все, что когда-нибудь может понадобиться. Бывает, что «озеро» становится «болотом данных» (Data Swamp), иначе говоря – «файлопомойкой», предупредил эксперт.

Затем создается хранилище данных (Data Warehouse) – для MPP-базы (то есть базы с массово-параллельной архитектурой) или набора таких баз, а также для всего, что имеет структуру, для обработанных и подготовленных данных.

Будущее машинного обучения

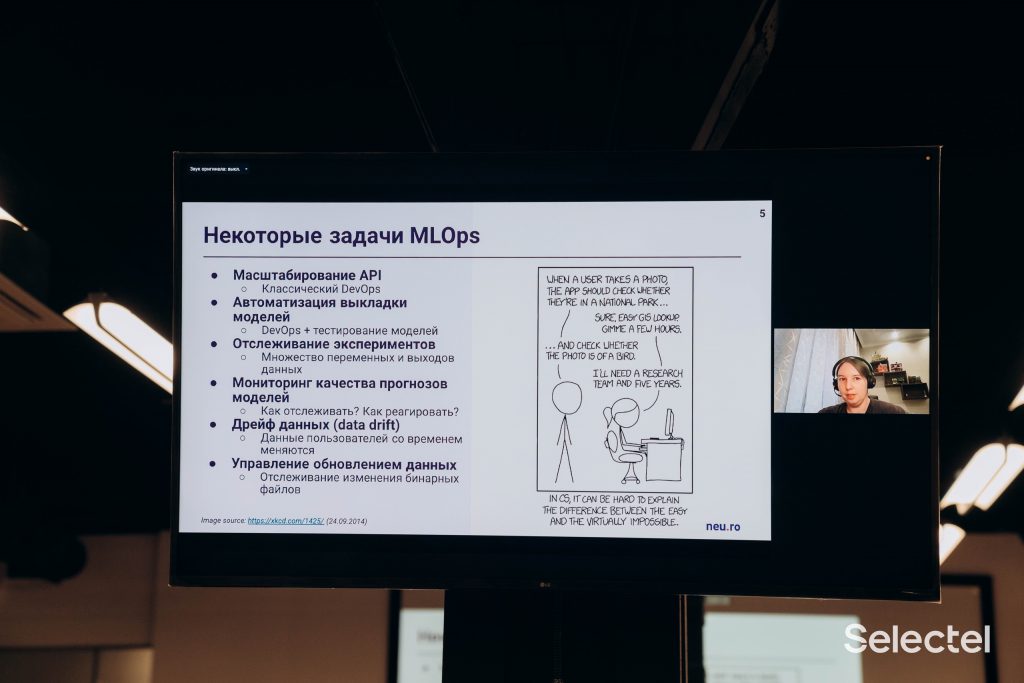

Почему в компаниях не хотят внедрять сложные ML-решения? Антон Чунаев, менеджер ML-продуктов Selected составил перечень сдерживающих факторов на основе опроса корпоративных клиентов:

- «Мы не можем внедрить готовую платформу MLOps, так как нам придется перестраивать все процессы разработки в компании»;

- «Мы уже используем инструмент X, переходить на другие нет ресурсов»;

- «Наша компания просто применяет для разработки Jupyter Notebooks с GPU (графическим процессором), а потом делает API для использования готовой модели»;

- «Хотим платить только за реальное потребление ресурсов, а не за простаивающие серверы».

«Разработчикам программного обеспечения и инженерам машинного обучения необходимы качественные инструменты для того, чтобы сделать качественные продукты», – это кредо Марии Давыдовой, head of product в компании neu.ro.

Эксперт озвучила требования к идеальной системе MLOps. К ним относятся:

- воспроизводимость – все эксперименты должны повторяться через версионирование ассетов и метаданных;

- масштабируемость – предполагает получение необходимых ресурсов как в облаке, так и в гибридной структуре;

- непрерывность – то есть атоматизация цепочки CI/CD/CT (непрерывных процессов интеграции, поставки и тестирования);

- коллаборация – совместная работа разных команд в одном окружении;

- ответственность – предусматривает управление правами доступа;

- этичность – для этого необходимы мониторинг и анализ работы моделей, объяснение результатов;

- перспектива – способность системы к развитию.

Мария отметила, что сейчас этичность – хайповый термин, причем не всегда понятно, как ее отслеживать. Недавний пример нарушения норм этики – широко обсуждаемый случай, когда система искусственного интеллекта соцсети Facebook приняла афроамериканцев в видеоролике за приматов. Под видео выводился вопрос «Продолжать смотреть видео о приматах?». Мария подчеркнула, что ML-модель должна поддерживать права различных групп, а не делить людей по национальному признаку, расовому, гендерному или какому-то иному.

По мнению Марии, любой компании в одиночку сложно выстраивать систему, которая отвечает всем этим критериям. Именно поэтому в начале 2020 года был создан альянс ALLA (All Infrastructure Alliance) – для формирования стандартов и канонического стека в ML-разработке. В альянс вошли более 60 организаций.

«Ни одна компания не может обеспечить идеальное решение. Будущее – за интеграцией между компаниями и специализированными инструментами», – убеждена эксперт.

И в 4 квартале 2021 года Selectel на базе платформы neu.ro запустит продукт, связанный с MLOps.

«Долорес» под контролем

Как службе поддержки клиентов сохранить свое человеческое лицо при использовании ML? Об этом рассказали представители «ВКонтакте»: руководитель поддержки Анастасия Федорова и продакт-менеджер AI Research Иван Самсонов. Компания придерживается такого принципа: любой автоматический ответ должен проходить модерацию агента.

Когда-то соцсеть не работала с платежными сервисами, поэтому не было необходимости обрабатывать вопросы пользователей в течение 10 минут, SLA был 24 часа. Но все изменилось – и в 2019 году «ВKонтакте» запустила первую ML-модель.

Иван с Анастасией рассказали: поначалу агенты опасались, что их разгонят из-за искусственного интеллекта. Но потом поняли, что модель должна не заменить их, а дать им возможность сконцентрироваться на более сложных задачах.

Как это работает? Модель генерирует варианты ответа на основе предыдущего опыта общения с пользователями. Агент выбирает ответ, ему не нужно вводить его руками. Предусмотрены опции «не подходит» (когда часть ответа необходимо дописать) и «не подходит совсем» (когда агенту приходится полностью составить ответ или перенаправить вопрос суперагентам).

Внутри главной генеративной ML-модели, названной «Долорес», работает целый ансамбль других. Например, антитролль-модель, модель life-is (находит ответы для пользователей, которые не троллят, но задают вопросы, напрямую не относящиеся к поддержке VK) или модель, которая распределяет вопросы по языкам и направляет нужным агентам.

Все эти инструменты позволяют службе поддержки соцсети закрывать KPI. Ключевые показатели эффективности учитывают качество ответа, время до первого ответа пользователю, время до закрытия вопроса.

«Мы поняли, что неважно, насколько качественный ответ получает пользователь, если его приходится слишком долго ждать. С применением ML-модели мы смогли увеличить скорость первой реплики в пять раз за последний год. И сэкономили нагрузку, которую бы взяли на себя примерно 30 человек с марта 2019 года», – поделилась результатами Анастасия Федорова.

Здоровый прагматизм

Между тем Валерия Дымбицкая, ведущий разработчик аналитических сервисов oneFactor, рассказала о результатах автоматического тюнинга параметров фреймворка Spark.

В компании есть продукт «Лидогенерация» – выбор из некоторого списка абонентов более узкой аудитории для целевого действия, например для обзвона. Выборка делается с помощью Spark ML Pipeline. При этом data-инженеры не знают, какие данные обрабатываются в моделях у клиентов, поэтому под каждый запуск раньше выделялся одинаковый объем ресурсов – оперативной памяти. И получалось, что в каких-то случаях этих ресурсов было недостаточно, а в других – наоборот, избыточно.

Когда число запусков этого продукта выросло в несколько раз, перед oneFactor встала задача более эффективного распределения ресурсов. Поэтому в компании разработали и внедрили систему, которая позволяет каждому применению модели выдавать оптимальные ресурсы и контролировать их – без участия человека. В компании подсчитали, что если все запуски будут работать одновременно и 1 секунду, то экономия составит от 1 до 200 Тб при текущей конфигурации.

В свою очередь Дмитрий Миронов, Solutions Architect AI компании Nvidia в России и СНГ, в своем докладе остановился на ускорении разработки и инференса решений на основе машинного и глубокого обучения. А Никита Тарасов, Head of Data Science в «Контур», – на векторных пространствах и поиске ближайших соседей (такой метод ML используется для решения задач классификации и регрессии).

Директор Национального центра когнитивных разработок, доктор технических наук Александр Бухановский рассказал о подходах к разработке и эксплуатации платформ на основе больших данных и машинного обучения.

Он также напомнил, что есть задачи, связанные с сильным искусственным интеллектом, который отражает высшие возможности человеческой деятельности, то есть способен на креатив – создание новых знаний путем обобщения накопленного опыта и наблюдаемых фактов. А другие задачи эффективнее решаются с помощью слабого искусственного интеллекта, к которому относятся методы компьютерного зрения, обработки естественного языка, анализа и синтеза речи, а также системы беспилотного транспорта.

При этом, как подчеркнул эксперт, когда мы говорим про общий искусственный интеллект (Artificial General Intelligence, AGI), то тоже имеем в виду прагматические задачи, например автоматическую разработку и обучение предсказательных моделей или генеративный дизайн. А вовсе не создание разума, которому люди будут поклоняться, как пишут в некоторых статьях.

Наталья ТРАВОВА