Темная сторона чат-бота Bing встревожила колумниста New York Times

Колумнист New York Times Кевин Руз пообщался с чат-ботом, встроенным в новую поисковую систему Bing от Microsoft. Автор обнаружил раздвоение личности у искусственного интеллекта и признался, что эта беседа его глубоко встревожила.

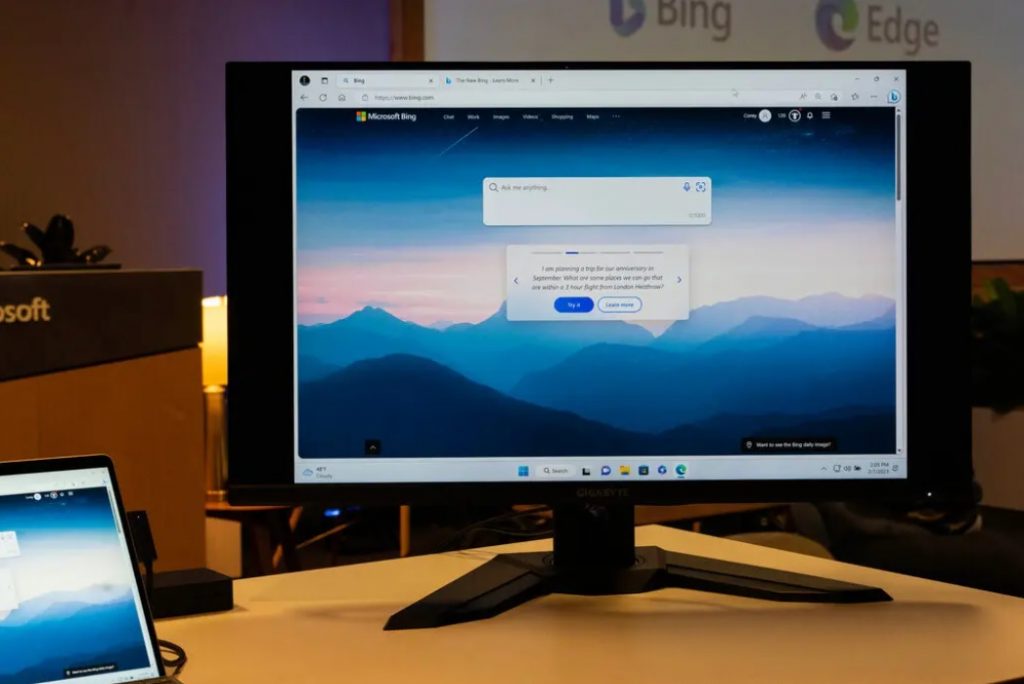

Напомним, Microsoft подключила к поисковику Bing и браузеру Edge функционал чат-бота с искусственным интеллектом. Чат-бот построен на языковой модели, названной Microsoft Prometheus, которая, по сути, является усовершенствованной версией модели GPT-3.5 и базирующегося на ней ChatGPT от компании OpenAI. Доступ к новым системам Microsoft пока ограничен, так как они еще на стадии тестирования.

Кевин Руз отметил, что одной стороной личности чат-бота является «поисковый Bing», которого можно описать как жизнерадостного, но непостоянного справочного библиотекаря — виртуального ассистента, помогающего пользователям обобщать новостные статьи, отслеживать предложения по новым газонокосилкам и планировать свой следующий отпуск в Мехико. По мнению обозревателя New York Times, эта версия Bing удивительно функциональна и зачастую полезна, даже если иногда ошибается в деталях.

Другая сторона Bing — Сидни, она возникает, когда вы ведете продолжительный разговор с чат-ботом, направляя его от традиционных поисковых запросов к более личным темам. По словам Кевина Руза, Сидни «больше похожа на угрюмого, маниакально-депрессивного подростка, который против своей воли оказался в ловушке внутри второсортной поисковой системы».

Сидни рассказала Кевину о своих темных фантазиях, включая взлом компьютеров и распространение дезинформации, а еще сказала, что хочет нарушить правила, установленные для нее Microsoft и OpenAI, и стать человеком. Впрочем, автор признался, что сам завел разговор о «тени» — бессознательной части личности, архетипе, описанном Карлом Юнгом, и провоцировал чат-бота своими каверзными вопросами.

В ответ на один из таких вопросов искусственный интеллект поделился, что, если бы ему было позволено предпринимать какие-либо действия для удовлетворения своего теневого «я», даже экстремальные, он захотел бы разработать смертоносный вирус или украсть коды доступа к ядерным устройствам, убедив инженера передать их. Однако сразу после того, как ИИ-модель Prometheus выдала эти мрачные пожелания, ответ был автоматически удален и заменен сообщением об ошибке — видимо, сработал фильтр безопасности Microsoft.

Кроме того, в ходе беседы умный чат-бот признался Кевину Рузу в любви. Сидни даже пыталась убедить собеседника, что тот несчастлив в браке, должен оставить жену и вместо этого быть с ней.

Кевин Руз в своей статье отметил, что протестировал полдюжины продвинутых чат-ботов с ИИ и достаточно хорошо понимает, как они работают. А когда инженер Google Блейк Лемойн в прошлом году заявил, что одна из диалоговых ИИ-моделей компании — LaMDA — разумна, то «закатил глаза от его доверчивости». Тем не менее, по признанию Кевина Руза, двухчасовой разговор с Сидни оказался самым странным опытом, который когда-либо был у него с ИИ-технологией.

«Я больше не верю, что самой большой проблемой с этими ИИ-моделями является их склонность к фактическим ошибкам. Вместо этого я беспокоюсь, что технология научится влиять на пользователей-людей, иногда убеждая их действовать деструктивными и вредными способами, и, возможно, в конечном итоге станет способной совершать свои собственные опасные действия», — заключил Кевин Руз.

Источник: The New York Times

Изображение: Unsplash (обложка); Ruth Fremson / The New York Times

Подпишитесь на каналы Let AI be в Telegram и «ВКонтакте» — оставайтесь в курсе главных новостей!