Библиотека YaFSDP ускоряет обучение больших языковых моделей до 25%

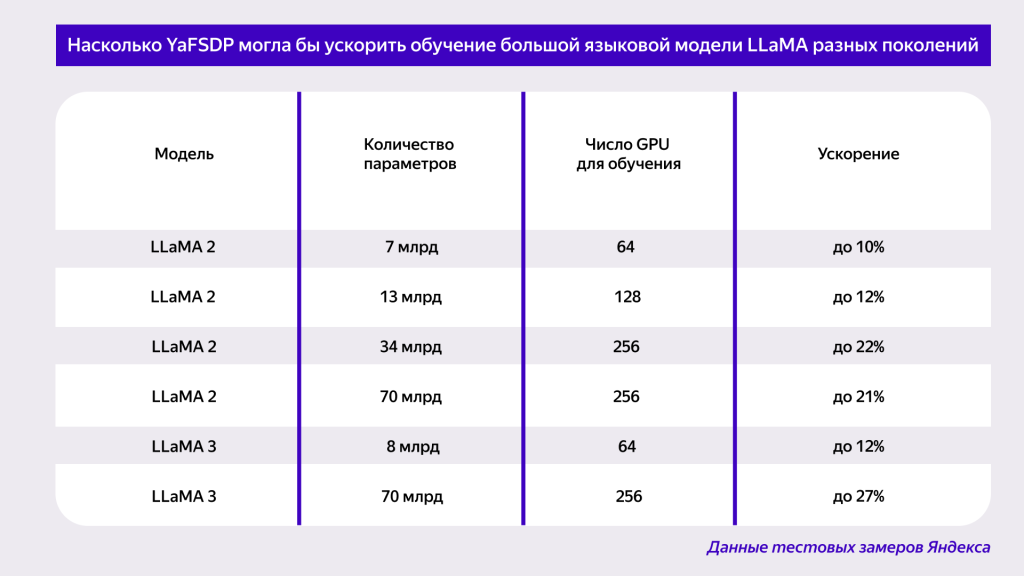

Компания «Яндекс» разработала и выложила в опенсорс свою библиотеку YaFSDP, которая ускоряет обучение больших языковых моделей (LLM) до 25%, в зависимости от их архитектуры. Она также подходит и для других нейросетей — например, генерирующих изображения.

В компании отмечают, что YaFSDP также позволяет сократить расходы на оборудование для обучения моделей — это особенно важно для стартапов и научных проектов. С помощью библиотеки можно расходовать до 20% меньше ресурсов графических процессоров (GPU) при машинном обучении.

Как пояснили разработчики, одна из сложностей в обучении больших языковых моделей — это недостаточная загрузка каналов коммуникации между графическими процессорами. YaFSDP это решает. Библиотека оптимизирует использование ресурсов GPU на всех этапах обучения: pre-training (предварительное), supervised fine-tuning (с учителем), alignment (выравнивание модели). Благодаря этому YaFSDP задействует ровно столько графической памяти, сколько нужно для обучения, при этом коммуникацию между GPU ничто не замедляет.

YaFSDP была создана «Яндексом» в процессе обучения генеративной модели нового поколения YandexGPT 3, а затем протестирована на сторонних нейросетях с открытым исходным кодом. Так, применительно к модели LLaMA 2, этап предварительного обучения на 1024 графических процессорах сократился бы с 66 до 53 дней.

Исходный код YaFSDP можно найти на GitHub.

Источник: «Яндекс»

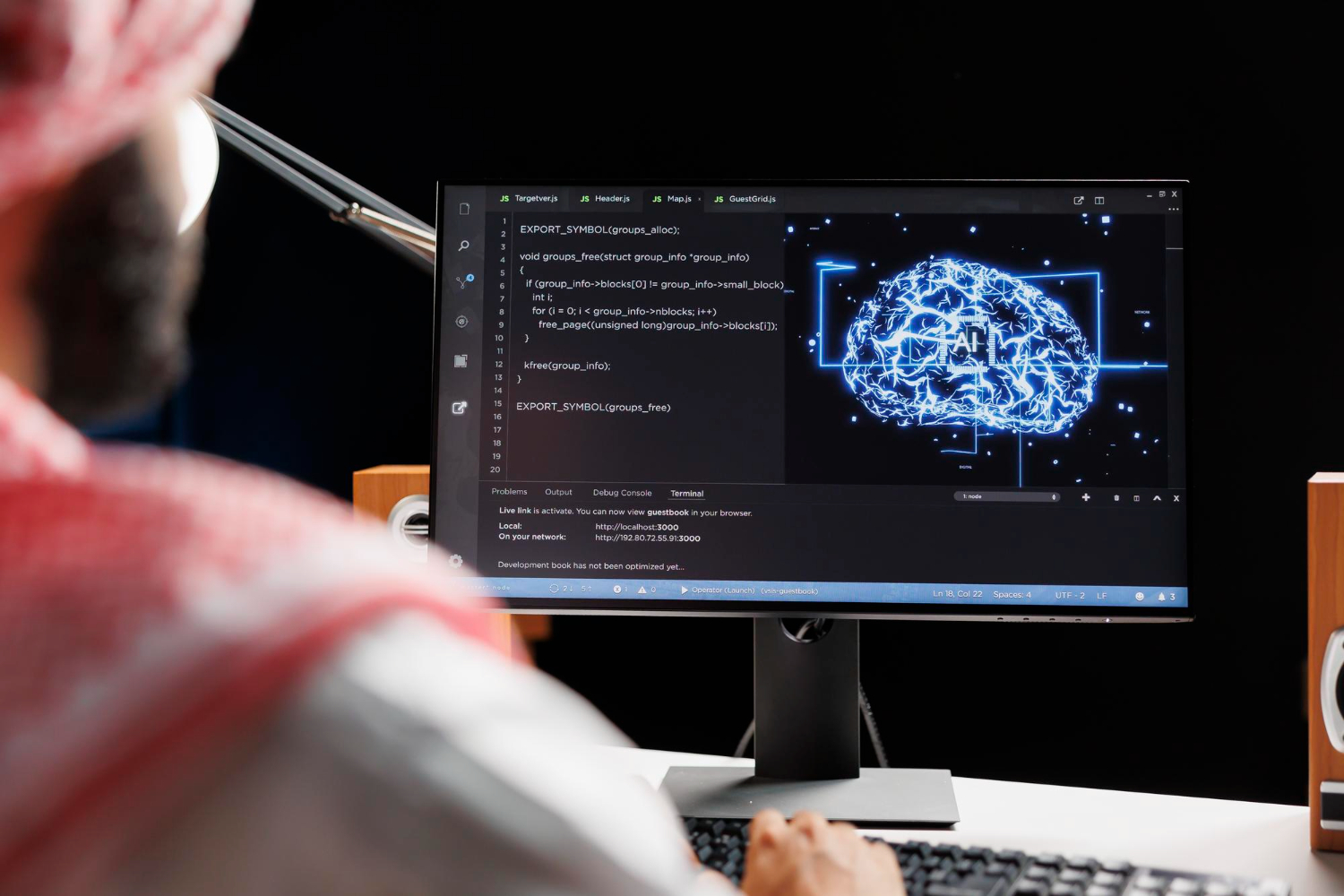

Изображение: Freepik (шапка)

Подписывайтесь на каналы Let AI be в Telegram и «ВКонтакте» — оставайтесь в курсе главных новостей в сфере искусственного интеллекта!